Immagina di guardare un video in silenzio e ritrovare, pochi istanti dopo, una descrizione in frasi complete generata a partire dalla sola attività cerebrale. È l’idea alla base del “Mind Captioning”, un metodo di decodifica che traduce le rappresentazioni semantiche del cervello in linguaggio naturale usando fMRI e modelli di deep learning. Lo studio pubblicato su Science Advances descrive un sistema che produce testi coerenti sia mentre un partecipante osserva un filmato sia quando lo ricorda, senza fare affidamento sulle tradizionali aree del linguaggio. Per approfondire la ricerca originale: paper su Science Advances.

Come funziona: dalla visione alla frase

Il protocollo sperimentale utilizza la risonanza magnetica funzionale per misurare il flusso ematico in aree visive e associative. I ricercatori mappano le caratteristiche semantiche contenute nei pattern neurali e le allineano con un modello linguistico che genera descrizioni. In pratica, non si decodificano parole “pensate” ma il significato rappresentato nei circuiti sensoriali: azioni, oggetti, contesti. L’algoritmo ottimizza iterativamente il testo, passando da etichette semplici a frasi sempre più ricche e strutturate che rispecchiano il contenuto mentale.

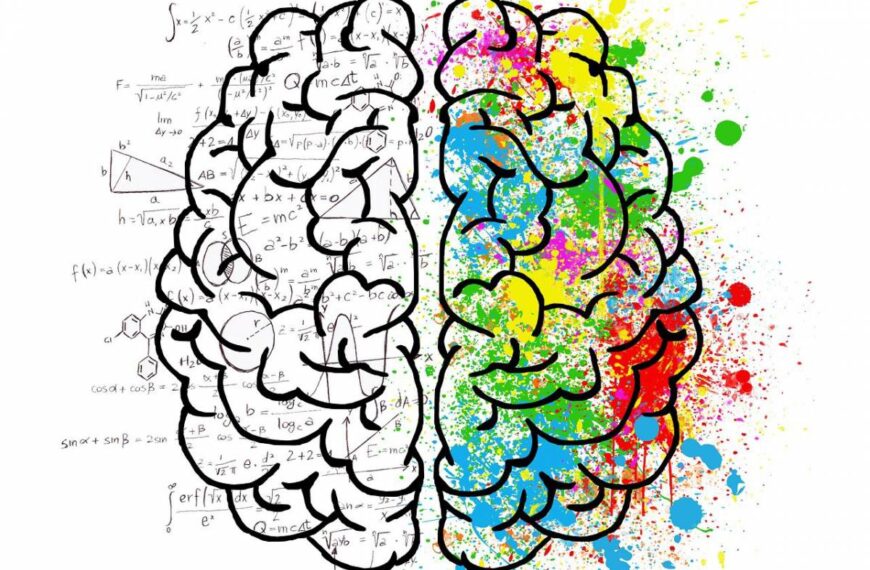

Decodifica senza linguaggio: perché è un cambio di paradigma

Le prime interfacce cervello-testo puntavano a leggere il parlato immaginato o i correlati del discorso interno. Qui, invece, la decodifica avviene in regioni sensoriali e associative che codificano concetti, relazioni e scene, aggirando la necessità di produzioni verbali o motorie. Questo spostamento apre scenari nuovi per la comunicazione assistiva e per lo studio della rappresentazione concettuale nel cervello umano.

La prova con memorie e immaginazione

Il punto più sorprendente emerso dagli esperimenti è la capacità del sistema di descrivere scene ricordate: ai partecipanti veniva chiesto di richiamare mentalmente i video, e il decodificatore produceva testi intelligibili e riconoscibili, sufficienti in alcuni casi a identificare il filmato originale tra alternative. Questo risultato suggerisce che le tracce mnestiche conservino un’organizzazione semantica accessibile alla lettura algoritmica.

Benefici potenziali per chi ha disturbi della comunicazione

Per persone con afasia, sindrome locked-in o patologie neurodegenerative, un canale di comunicazione che non dipende dai centri del linguaggio o dall’apparato motorio può diventare fondamentale. Il Mind Captioning, operando su rappresentazioni pre-verbali, potrebbe aiutare a “dire” ciò che si vede, ciò che si ricorda o ciò che si immagina, restituendo autonomia comunicativa là dove i mezzi tradizionali sono compromessi.

Mappare il significato: che cosa “vede” il modello

I decodificatori lineari trasformano i pattern fMRI in vettori di caratteristiche semantiche. Queste caratteristiche vengono poi allineate a uno spazio linguistico per guidare la generazione delle frasi. Il sistema è sensibile a elementi come agenti, azioni, luoghi, relazioni tra oggetti; ricostruisce l’ossatura narrativa della scena, più che dettagli ottici fini. In termini cognitivi, è un’istantanea di come la corteccia visiva e le aree associative integrino percezione e concetto.

Limiti tecnici: fMRI, dati per-soggetto e generalizzazione

La fMRI offre risoluzione spaziale adeguata per inferire rappresentazioni complesse, ma è costosa, ingombrante e relativamente lenta sul piano temporale. Inoltre, la calibrazione del modello richiede molte sessioni per ogni partecipante: un ostacolo alla scalabilità. Restano aperti problemi di trasferimento tra individui, robustezza cross-dominio e riduzione della dipendenza dal singolo scanner o protocollo.

Etica e privacy mentale

Decodificare contenuti mentali introduce sfide delicate: consenso informato, limiti d’uso, protezione dei dati neurali, rischio di inferenze indesiderate. La ricerca propone scenari terapeutici ed educativi, ma ogni passo richiede linee guida chiare su proprietà, portabilità e cifratura dei dataset neurali, oltre a contromisure contro usi impropri.

Applicazioni a breve e medio termine

Nel breve periodo, il Mind Captioning può diventare uno strumento di laboratorio per indagare la rappresentazione semantica in condizioni naturali, valutare l’efficacia di riabilitazioni cognitive e testare modelli computazionali della visione. Nel medio termine, l’integrazione con sensori più accessibili (magnetoencefalografia portatile, fNIRS a canali densi) e con modelli linguistici multimodali potrebbe ridurre il bisogno di fMRI senza sacrificare eccessivamente l’informazione.

Architettura del sistema: pipeline in breve

- Acquisizione fMRI: registrazione dell’attività in aree visive/associative durante visione o richiamo di video.

- Decodifica semantica: regressori mappano voxel-pattern in embedding concettuali.

- Allineamento linguistico: lo spazio semantico guida un modello di linguaggio mascherato in un processo di ottimizzazione iterativa che evolve da parole chiave a frasi.

- Valutazione: misure di somiglianza semantica e compiti di identificazione del clip originale.

Verso un dizionario della mente

L’idea di costruire un lessico intermedio che colleghi rappresentazioni neurali e concetti apre opportunità per cartografie funzionali più precise e per interfacce più trasparenti. Un “dizionario” condiviso tra modelli neurali e modelli linguistici può facilitare il controllo dell’output, la personalizzazione e la spiegabilità delle frasi generate.

Frontiere di ricerca: generalizzare tra compiti e individui

Tra le priorità: ridurre il tempo di addestramento per-soggetto, migliorare la sensibilità ai contenuti astratti, aumentare la robustezza a distrazioni e variazioni di attenzione, rendere espliciti i meccanismi che legano contesto, azione e ruolo semantico. L’unione tra dataset condivisi, metriche standard e benchmark aperti renderà più confrontabili i risultati e accelererà il trasferimento tecnologico.

Interfacce cervello-macchina: dal laboratorio alla clinica

Il Mind Captioning si inserisce nella traiettoria delle BCI non invasive che puntano a una comunicazione rapida e naturale. Sistemi ibridi che combinano segnali neurali e segnali comportamentali (oculometria, micro-movimenti) potrebbero bilanciare accuratezza e praticità. Una roadmap realistica prevede prototipi clinici per pazienti selezionati, test sul campo e validazioni longitudinali per monitorare apprendimento ed effetti collaterali.

Imparare dal cervello per migliorare i modelli

Allineare spazi semantici neurali e linguistici è anche un banco di prova per i modelli generativi: vincoli biologici possono ridurre allucinazioni e orientare l’output verso descrizioni più ancorate al contenuto. La convergenza tra neuroscienze computazionali e NLP suggerisce che comprendere come il cervello costruisce significato aiuti a progettare IA più affidabili e interpretabili.

Prossimi passi: “cerebrale” al centro dei sottotitoli della mente

Portare il sottotitolaggio della mente fuori dallo scanner richiederà sensori migliori, modelli più efficaci e protocolli standardizzati. La posta in gioco è alta: una comunicazione davvero inclusiva che parta dalla realtà cerebrale delle persone, trasformando percezioni, ricordi e immaginazione in parole utili per comprendere, curare e connettersi.

Quadro sinottico: “cerebrale”, semantica, linguaggio

- Input: attività cerebrale misurata con fMRI durante visione o richiamo.

- Ponte: embedding semantici decodificati dalle aree visive/associative.

- Output: frasi generate e ottimizzate da un modello di linguaggio condizionato sugli embedding.

- Uso: comunicazione assistiva, ricerca cognitiva, strumenti didattici e clinici.